越来越多的媒体和智库开始担心基于选举的民主政治制度,甚至可能无法承受这种技术之重。

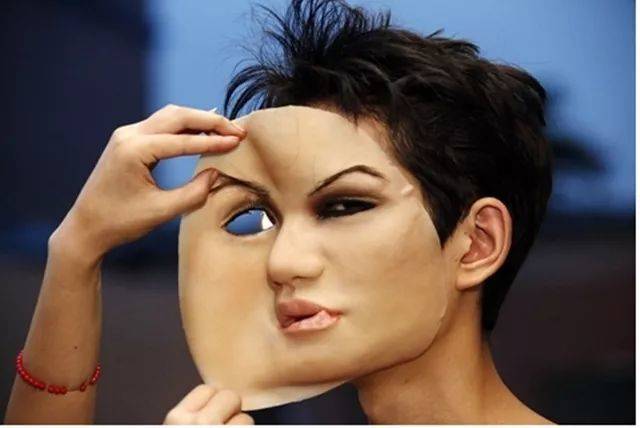

如果你的脸被嫁接到AV里,声音被用于诈骗电话

我们过去说,历史是个任人打扮的小姑娘,那么现在,现实也是了。

几个月前,以ZAO为首的换脸视频在中国突然大火,上传一张照片,迅速得到自己为主角的小视频,这是广大人民群众跟深伪的第一次亲密接触。然而,马上就有质疑指出其中对于个人隐私的潜在风险,以及深伪跟色情产业的微妙联系,于是,我们跟深伪的“贴面舞”来去匆匆。

然而,根据我在美国华府所见,对于深伪,美国政界、学界的警惕远超中国—近期,随着美国总统大选的临近,越来越多的媒体和智库开始担心基于选举的民主政治制度,甚至可能无法承受这种技术之重。

01

一段在YouTube上走红的、前总统奥巴马爆粗现总统特朗普的视频,可以看做是深伪的牛刀小试。视频中,奥巴马在疑似白宫办公室的地方,以经典的奥巴马腔,一本正经的说特朗普是个彻底的XX。

视频不是真的,但美国人民的担心确实是。

据CNN的报道,五角大楼为应对深伪,拉上几家最牛的研究机构和实验室,成立了“先进研发项目防御局”(DARPA)。甚至有官方声音称,这个技术具有武器级的重大威胁;Facebook据说也砸下重金,研发深伪识别技术。不管华盛顿还是硅谷,现在媒体也掺和进来,同声合唱对这种造假技术的天大的担心。那到底这个让美国寝食不安的深伪是什么?

深伪(Deepfake),简单说就是一种软件技术,由AI执行,可以对被模仿者的面部建模,来合成天衣无缝的伪造视频。深伪的神奇之处在于,即便你从未做过那些事,说过那些话,去过那些地方,碰到深伪,一切都不是问题,一切都能让围观群众的眼睛信以为真。

除了奥巴马,YouTube上还有一大票名人深伪,小布什、小扎、尼古拉斯凯奇……深伪,像黑暗中蛰伏的猛兽,正蠢蠢欲动。

一般来说,要深伪,首先要搜集被模仿者的原始素材,包括视频、声音和照片,然后通过专门的软件,模仿你的表情、习惯、声音、肢体动作,甚至说话节奏。在无人提醒的情况下,深伪很难被察觉,即便有人提醒,在高手制作的视频面前,你也很难确认那是“真的假”。

02

深伪首次引起公众注意是在2017年,Reddit的某些无聊用户,把一位名人的脸和一部色情片深伪了一下。现在,随着机器深度学习的推进,深伪技术一日千里—大量原始素材?漫长的制作时间?超强算法能力?这些以前的条件现在统统不需要了。

这么说吧,通过开源软件,即便不专业的人,也可以轻松深伪。当然,你极客,非要达到乱真的效果,那确实还需要点专业能力。但对比两年前,深伪粉可以拍胸脯问,随着技术的迅速成熟,这一门槛被踏平的日子还会远吗?

03

深伪的力量不仅取决于它们看上去有多真,更重要的是它们传播的有多快。

人们深信自己的眼睛,这是进化赋予我们的本能。千百年来,我们就是靠着双眼所见来判断真伪,做出决定。但这种本能适应的是那个真实世界,那个双眼不会被轻易欺骗的世界。面对这个眼见不为实的新世界,人类的生物进化和认知能力已经被技术进化和AI耍的团团转。

当一个爆炸性的深伪视频通过互联网和手机推送到你面前时,即便几分钟后就被澄清那是个假消息,但就在这短短的片刻之内,它可能就已经扩散给数以千万计的人。在大众心理学中,面对两个截然相反的消息,那个不同寻常的更容易被接受。

因此,即便面对澄清,我们也往往会认为那不过一种官方的掩饰手段。设想,当你面对两个都说对方是假的视频,而视频本身看上去都如此真实,你会如何做判断,而且,如果不是两个,而是同时有三、四个罗生门般的视频,估计大部分正常人都会被彻底搞晕。

自媒体的兴起是这一问题的催化剂,因为没有“中间商赚差价”,理论上,所有人都可能把深伪视频直接推给所有人。未来,真要深伪,根本不需要一个团队,一人足矣!

设想一下,一个不怀好意的深伪极客,躲在自己房间里就有可能引发一次现象级的信息海啸,当无数海啸以迅雷不及掩耳盗铃之势铺天盖地而来时,一个充满混乱和无所适从的时代必然随后而至。

04

仅在2019年,1.5万个深伪视频已经上网,其中96%都是色情视频。事实上,已经有人因此深受其害。

Rana Ayyu,一位印度女调查记者,因为报道触怒了了不少网民,她的穆斯林身份,更是给她带来经常性的社交媒体暴力。去年4月,一名8岁的克什米尔小女孩被强奸,Ayyu在BBC的报道中,批评印度政府对频发的儿童性犯罪打击不力。

第二天,先是有人伪造她的推特截图,说“我恨印度和印度人”“我爱巴基斯坦”“我赞同儿童被强奸,只要是以伊斯兰教的名义”。

更可怕的是第二天,当她约了朋友在咖啡馆商量怎么对付这些事的时候,接到编辑的信息和一条链接,点开一看,是一部她做主角的色情片—别有用心者把她的脸深伪到了一部色情视频中作为报复。

Ayyu崩溃到进了医院,之后即使她做了很多努力,但无论她如何澄清这一切,她的每一条社交媒体发言后永远跟着无数的谩骂,其中夹杂着大量这部深伪色情片的截图。

更有甚者,2018年6月,还是在印度,一部儿童被绑架的视频引发了多起暴乱,8人被杀,其中5人仅仅是因为路过一个村庄,下车后跟一个当地女孩说了句话,就被随后赶来的至少35个村民围殴致死,随后赶来的警察也没能幸免,至少4名警察被打伤。

而这部网上传的沸沸扬扬的所谓儿童绑架视频,其实是被深伪的一部巴基斯坦儿童安全活动的资料片,面对这种无中生有的荒诞悲剧,人们不禁在想,在未来这些会不会成为某种常态。

深伪不仅影响一些社会议题,甚至成为新型经济犯罪的手段。根据华尔街日报报道,一家英国能源公司,被犯罪分子利用AI合成技术,模仿公司CEO的声音,骗走了24.3万美元。

设想,在电信诈骗如此泛滥的今天,如果你的家人,特别是老年人,听到你“亲口”说要转账多少应对某个“紧急”情况,他们会怎么做?或者你自己,听到你孩子的班主任,或者你的爱人在电话里焦急的告诉你孩子“出了车祸”,让你赶紧打一笔急救费,你会怎么做?电话不行,那深伪一个视频电话又如何?普通人在深伪面前几乎毫无还手之力。

05

美国即将迎来2020年总统选举,情报部门发出警告,按照目前深伪技术发展的速度,很有可能政治对手之间会有冲动利用它,在“关键时刻”给对手致命一击,特别是那些处于不利地位的候选人,精心准备一个足以让对手翻盘的话题,然后搜集对手的照片和视频(对于公众人物来说,没有任何难度)。

深伪一个含有某些真实的假视频,然后在对手根本来不及辩解的时刻,比如投票前几个小时利用无法追踪IP的技术上传到所有的社交平台,那将造成巨大的混乱,甚至颠覆性的结果。

这种改造其实并不是什么新东西,早在80年前,斯大林就把他的政治对手,一个个从过去的公开照片中“清除”出去。1990年代,Photoshop给了修图师先进工具,从而我们有了P图的概念。而现在,正如一位研究者所言,也许人类正在跨入一个“真实世界崩溃的大时代”。

BBC的新剧《真相捕捉》讲了男主陷入一场绑架和谋杀指控,而“作案的全过程”都是由街头的视频探头被检测中心当场看到的,而事实上,这一切不过是利用深伪技术合成的。这部新剧从法律角度发出了质疑:如果深伪能够任意制作视频,那么现在法庭的视频采信证据将不足为凭,而这将深刻影响各国的审判体系。

《真相捕捉》剧照

06

怎么办?

第一个办法当然是增强识别能力,用AI去对付AI。五角大楼组织的DRPA事实上就是这个思路的产物。除了研发新型识别软件,同时还需要改造硬件,比如在手机、摄头、录像机,甚至图形工作站等等涉及深伪制作的硬件中烧入隐含识别码,这样便于追踪视频的来源。

然而,哈利·法瑞德,一位著名的图像识别专家认为,目前的图像识别技术已经被深伪远远甩出几条街。我们现在更有可能的不是识别出哪些是假视频,而是被假视频愚弄,认假为真。

在10月底华盛顿著名智库CSIS举行的一次深伪研讨上,与会专家提出要加强对于公众的深伪教育。但是,如上所述,即便所有人都知道深伪的存在,我们难道就有能力辨别么?充其量,我们会对所有的事情将信将疑,而日常生活中对于事实和确定感的丧失,最终结果就是我们将越来越凭借个人的喜好和主观行事。

自文艺复兴以来建立的客观和理性大厦,将逐渐被侵蚀,另一种“迷信”将弥散到人类社会中去。直到某一天,我们不借助AI就无法判别真相的时候,谁掌握了AI,理论上,谁就具备了左右真实世界的力量。

专家同时指出,辨别真伪要倚重消息源,这个提法跟倚重AI本质上没有区别。互联网本身是去中心化的产物,在它诞生半个世纪之后,我们要再次投靠中心化、权威和认证来保障真实吗?这不仅是理念之争,背后有着一个更本质的问题:如果我们只相信权威机构和平台的信息,那么谁来监管它们?

如果它们被操控,丧失了真实客观,谁有能力来纠正,谁又有能力来告知我们真相—即便真相摆在面前,但因为它们不是来自于权威和中心,因此真的也为假,没有人会相信。到那时,我们就会成为传说中那些永远叫不醒的人。

还有学者提出要借助法律,也许吧。在美国弗吉尼亚州已通过法律,禁止深伪色情视频;加州和德州更把用于选举的深伪行为视为犯罪……然而,这真的行得通吗?

07

在CNN的深伪专题中,专家们认为这种技术必将极大的影响世界,甚至改变历史进程。

试想如果阿姆斯特朗时代有深伪技术,那么谁会真的相信美国人登上过月球?又或者,那段导致尼克松下台的水门事件的电话录音,也根本毫无说服力,那么这位开创了中美邦交正常化的总统,大概率不会被国会启动弹劾,从而获得连任。

由此想到上个月在“乌克兰电话门”旋涡中心的特朗普,怪不得气定神闲,也许官司真打起来,一段音频恐怕已经很难像当初那样有杀伤力。

借用深伪视频里“奥巴马”的话说,既然你的敌人可以让你在任何时间、任何地点说任何话。那么你其实可以不认任何你说的话,无论真假。